Введение

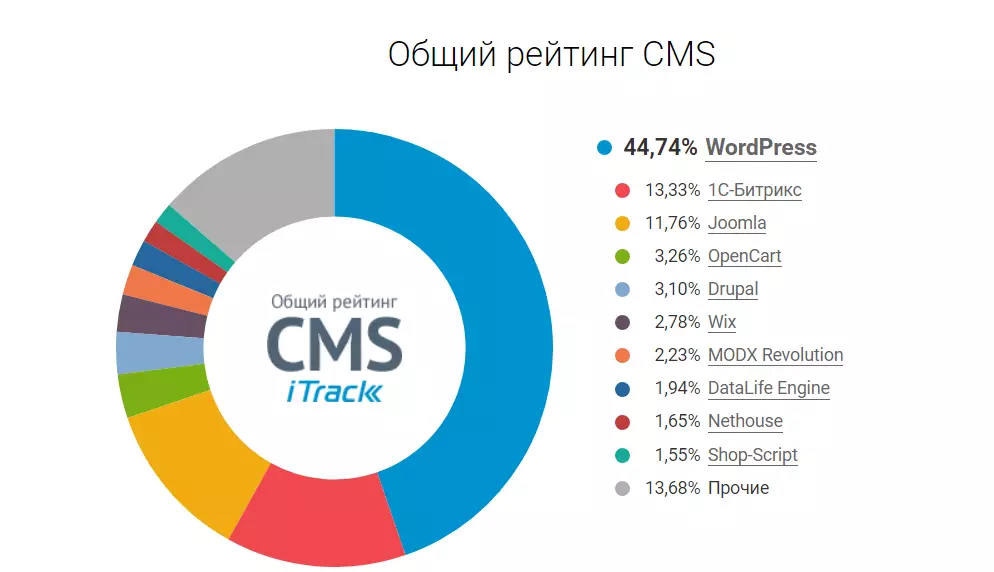

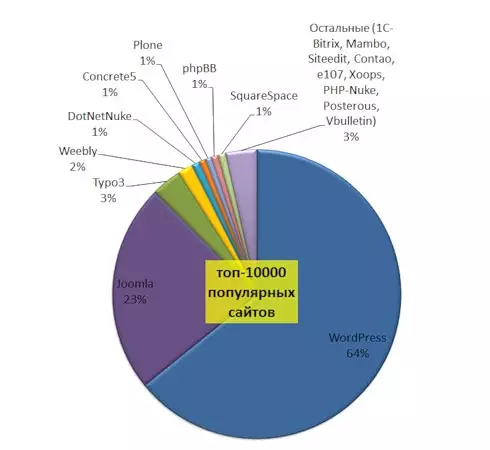

Согласно статистике исследований еще в 2013 году 1С-Битрикс занимал 3 место в рейтинге CMS. В 2017 году 1С-Битрикс одним из первых реализовала решение для соблюдения закона 54-ФЗ РФ. Так владельцам интернет-магазинов удалось избежать штрафов от налоговой (10 000 – 30 000 рублей).

В 2020 Битрикс вышел на 2-е место после Wordpress. В рейтинге Wordpress опережает Битрикс на 30%, потому что на нем много блогов и одностраничников. Популярность 1С-Битрикс в рунете растет с каждым годом, а подстройка под реалии происходит быстрее чем у других CMS. Поэтому среди решений для бизнеса Битрикс давно и прочно занимает первое место.

Сегодня мы рассмотрим преимущества и недостатки бесплатных CMS по сравнению с 1С Битрикс, чтобы ответить на главный вопрос этой статьи: Зачем переносить сайт с бесплатных CMS на 1С-Битрикс.

Стоит отметить, что некоторые владельцы сайтов предпочитают CMS, которые не входят в ТОП 5 это: InstantCMS , MaxSite, LiveStreet, OsCommerce, PrestaShop, Danneo, PHPShop, MODX, PHP-Nuke, TYPE03, Evolution CMS, Zen Cart.

Рассматривать данные движки мы не будем по причине их низкой популярности. Но если у Вас сайт именно на этих CMS, то мы можем проконсультировать лично. Просто напишите или позвоните нам по контактам вверху и внизу страницы.

Сравнение бесплатных CMS с 1С-Битрикс

Для начала немного фактов о двух лидирующих CMS: Wordpress и 1С-Битрикс

|

Параметры |

WordPress |

1С-Битрикс |

|

|

Лицензия |

Бесплатная |

Платная |

|

|

Для каких сайтов подходит? |

Блог, Landing Page, Визитка |

Визитка, Интернет - магазин, Крупный портал |

|

|

Системные требования |

Языки программирования |

PHP (версия 7.4 и выше) |

PHP (версия 7.1 и выше) |

|

БД |

MySQL (версия 5.6 и выше), MariaDB (версия 10.1 и выше) |

MySQL (версия 5.6 и выше) |

|

|

ОС |

Windows, UNIX |

Windows, UNIX |

|

|

Веб-серверы |

Apache, nginx |

Apache |

|

|

Безопасность и производительность |

Ограниченные функции при базовой конфигурации |

Высокий уровень защиты и производительности |

|

|

Возможности самостоятельного конфигурирования |

Гибкая система, легкое масштабирование |

Широкие возможности для масштабирования |

|

|

Удобство использования |

Простая настройка и установка, много руководств |

Возможны трудности для новичков, желательно сопровождение проекта |

|

|

Встроенные модули |

Отсутствуют. Есть много платных и бесплатных плагинов |

Количество встроенных модулей зависит от редакции системы |

|

Рассмотрим основные параметры CMS:

- Безопасность и производительность

- Встроенные модули

- Возможности самостоятельного конфигурирования

- Удобство использования

Безопасность и производительность

Главный минус бесплатных CMS - это, как ни странно, то, что они бесплатные. Из-за этого скачать их может кто угодно, чтобы изучить код и написать свой вирус.

Например, в нашей практике был случай, когда сайт на вордпресс взломали, но никто этого не заметил. Потому что сам сайт работал в прежнем режиме, но внутри создалось больше 1 000 страниц, внешне похожих на ответы@mail.ru и содержащих вирусные ссылки.

В 1С-Битрикс же встроено 18 модулей защиты, которые помогают защитить сайт от взлома и кражи данных, DDOS-атак и так далее.

То же самое касается и производительности. Но подробнее об этом расскажем в следующем пункте.

Встроенные модули

Большинство бесплатных CMS (Joomla, Opencart, Drupal) не имеют встроенных модулей. Все их приходится устанавливать дополнительно. Причем просто установить плагины и сразу работать с ними не получится.

Во-первых, надо будет следить за тем, чтоб все плагины были проверены и совместимы между собой. Плюс каждый из них надо будет отдельно настраивать.

Во-вторых, большое количество плагинов сказывается на производительности сайта и скорости его загрузки. К тому же, некоторые дублируют функции друг друга, но и удалить их никак, потому что в чем-то важном они друг друга дополняют.

Как вы понимаете, всё это требует дополнительных затрат времени и нервов. Стоит ли это денежной бесплатности - каждый решает для себя сам.

В случае же с 1С-Битрикс, количество встроенных и оптимизированных друг под друга модулей зависит от купленной вами редакции.

Так, например, в лицензии “Бизнес” есть возможность создания наборов похожих товаров, указание нескольких складов, нескольких цен для одного и того же товара, в зависимости от статуса клиента и так далее. Плюс интеграция с 1С происходит гораздо быстрее и только со стороны компьютера, а не сайта. Так что база 1С защищена, даже если вдруг сам сайт взломают.

Возможности самостоятельного конфигурирования

WordPress, Joomla, OpenCart, Drupal имеют гибкую систему и широкие настройки, позволяющие сделать из сайта всё то, что вы хотите. Для этого нужно будет устанавливать дополнительные плагины и шаблоны внешнего вида сайта. Хотя в OpenCart сложнее править дизайн, так как на платформе не предусмотрен визуальный редактор.

Для всего этого придется либо нанимать программистов, либо платить за платные версии тем и плагинов и каждый год их продлевать.

С Bitrix ситуация в чем-то похожая. Можно сэкономить и установить готовое решение из маркетплейса (аналог плагинов и тем в бесплатных цмс), а можно заказать создание полностью уникального сайта или какого-то дополнительного функционала.

Удобство использования

Большинство систем имеют простую настройку и установку, множество руководств. Конечно, в этом плане 1С-Битрикс немного сложнее Wordpress и Joomla. Но плюс 1С-Битрикс в том, что их техподдержка работает круглосуточно. К тому же, если вы заказываете перенос сайта у партнеров Битрикса, то вам должны предоставить команду разработчиков для сопровождения и гарантию на работу.

Топ-4 причины переноса сайта с бесплатных CMS на 1C-Битрикс

Перенос с бесплатных CMS на 1С-Битрикс - одна из самых популярных наших услуг. Поэтому мы собрали ТОП-4 причины, с которыми к нам обращаются клиенты.

Причина №1 Сложность в подключении онлайн-касс

Однажды к нам написал человек с проблемой подключения онлайн-касс, у которого был интернет-магазин на Joomla. Он был в отчаянии и хотел уже делать разработку на API, так как получил несколько штрафов, а Яндекс.Касса никак не подключалась. Мы убедили клиента, что перейти на Битрикс будет выгоднее.

Разработка длилась 45 дней. Яндекс касса работает, производительность выросла, закон закон ФЗ-54 соблюдается и данные автоматически отправляются в налоговую.

Причина №2 Возможности самостоятельного конфигурирования, масштабирование

К нам обратился сервисный центр по заправке картриджей. Сайт был на Wordpress и тормозил, это снижало конверсию. Также клиент хотел добавить:

- Собственные опросники

- Кастомизированную корзину

- Сложный поиск

- Оптимизацию сайта под Google PageSpeed Insights

Мы перенесли сайт с вордпресс на битрикс и добавили нужный функционал, благодаря чему у клиента выросло количество клиентов с сайта почти в 1,5 раза.

Причина №3 Безопасность и производительность

Часто пользователи WordPress и Joomla сталкиваются со взломами страниц и снижением производительности. Все из-за открытого исходного кода. Можно конечно поковыряться в нем. Но это потребует дополнительных вложений. А также отказа от ряда плагинов и расширенного функционала.

Популярность взлома сайтов на 1с-битрикс – менее 3%, в то время как Wordpress и Joomla лидируют по показателям.

Причина №4 Некому сопровождать проект

Еще у одного клиента был сайт на Drupal – заведомо сложная система для новичков. Админ и подрядчик, которые занимались сайтом – ушли. Возник коллапс. Сайтом заниматься некому, как вносить изменения никто не знает.

Решение: сделали переход на Битрикс. Клиент обращался с массой вопросов, которые в конце концов удалось решить. Проект сделали автономным, сайтом управлять стало легко.

Вывод

Как можно было понять из статьи, бесплатные CMS - являются такими только в самом начале. Для решения большинства бизнес-задач придется либо докупать дополнительные плагины, либо тратить своё время и нервы на их изучение.

Несомненно, если у вас небольшой проект, который особо не планируется расширять и нужно чтобы сайт просто был, то битрикс вам не нужен. Лучше потратить эти деньги на что-то другое.

Но если вы хотите сделать из сайта эффективный инструмент повышения продаж, то лучше задуматься о переходе на 1С-Битрикс. Не даром она более 7 лет занимает лидирующее место, как CMS для российского бизнеса.

Либо свяжитесь с нами любым удобным вам способом и мы ответим на все ваши вопросы. Телефон в Москве +7 (495) 230-20-53, почта info@wrp.ru.